どうにも今まで書いてきた内容がプロっぽくないのですけど、さらにプロっぽくない感じの内容をアップしていきます。今回は、Flutterが使えるようになるまでのお話です。秀和システムから出版されている『Android/ iOSクロス開発フレームワーク Flutter入門』を買ってきまして、これからFlutterを使ってみたいと思います。

それで、ざっと書籍に目を通してみまして、一番最初に「マジか~」と思った点ですが、「Windowsでは、iOSアプリのビルドができない。」という点ですね。ぼくはWindowsマシンを使っていますので、ちょっとがっくりきました。アプリ開発は、macOSの方が有利、ということなのですね。まあ、当然と言われればそうなのでしょうけど、macOSからはどちらもビルドできるなんて、、、今までずっと抵抗していましたけど、そろそろ乗換時期なのかなぁ。MacProもかっこよかったし。。。

はい、気を取り直して。まずはFlutter SDKのセットアップをします。書籍には色々と書いてあったのですけど、公式ホームページの手順に従ってやっていきたいと思います。基本的にはzipファイルをダウンロードしてきて、PATHを設定するだけで完了のはずです。

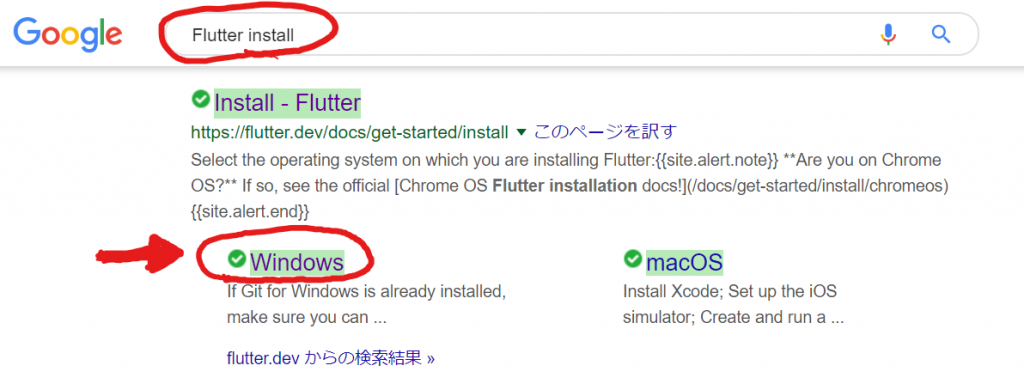

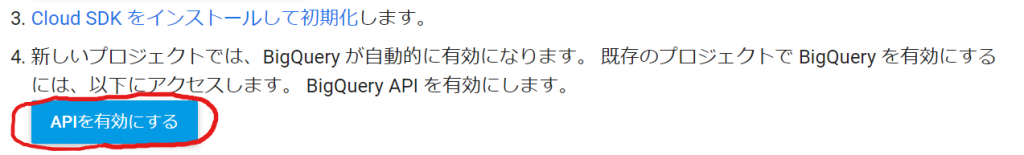

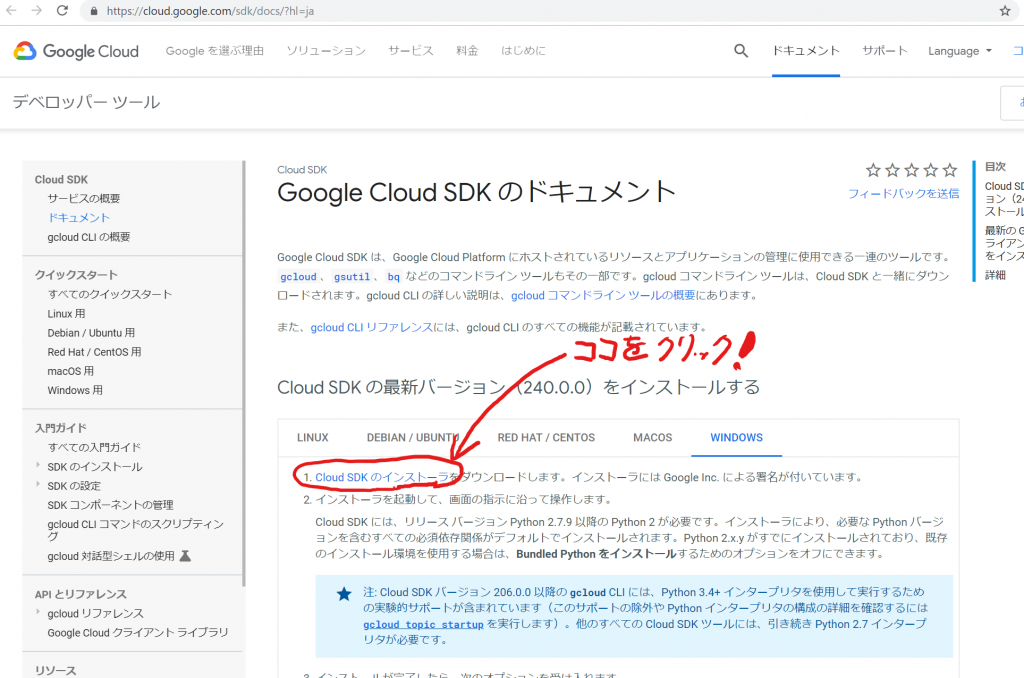

まずはGoogle先生に「Flutter install」を聞いてみます。動画の次にインストール方法が出てきました。

ぼくの環境はWindowsですので、こちらをクリックしました。

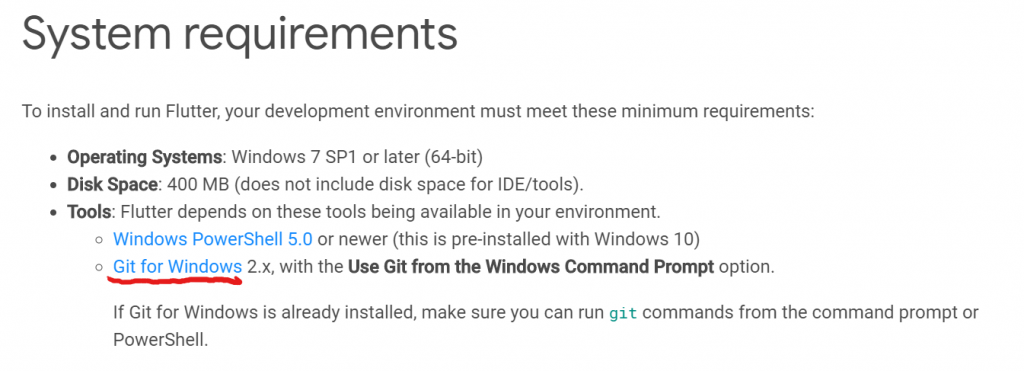

システム必要要件です。OSはWindows10を使っていますので、問題ありませんね。ディスクもたくさん用意してありますので、問題ありません。そして、ToolsのWindows PowerShell 5.0以上は、Windows10の場合はプリインストールされている、ということですので、気にしなくてよさそうです。最後の「Git for Windows」が必要ですね。ホントにいるのかなぁ、と、思いつつも、入れておくことにします。

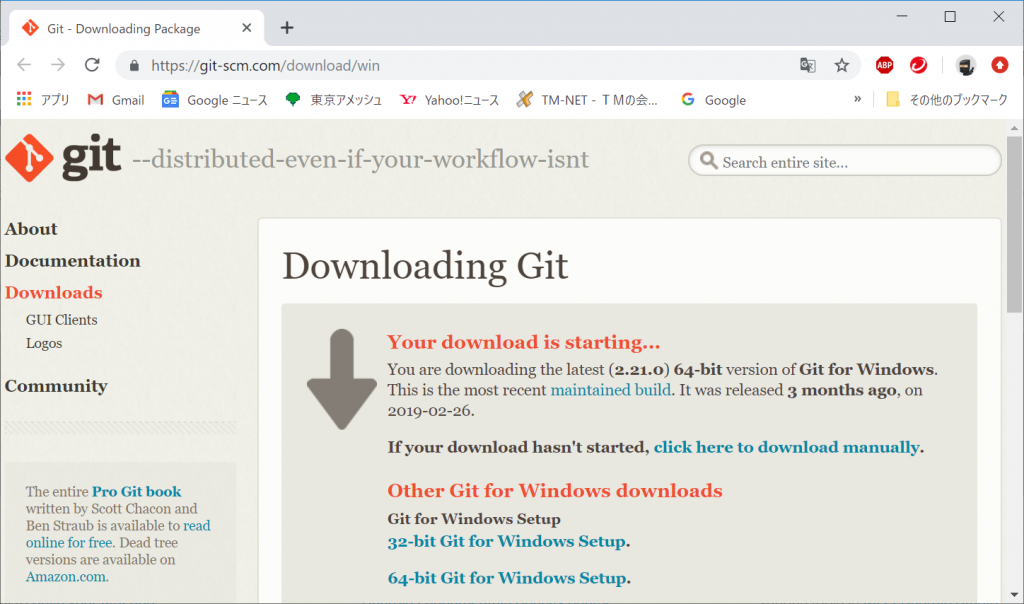

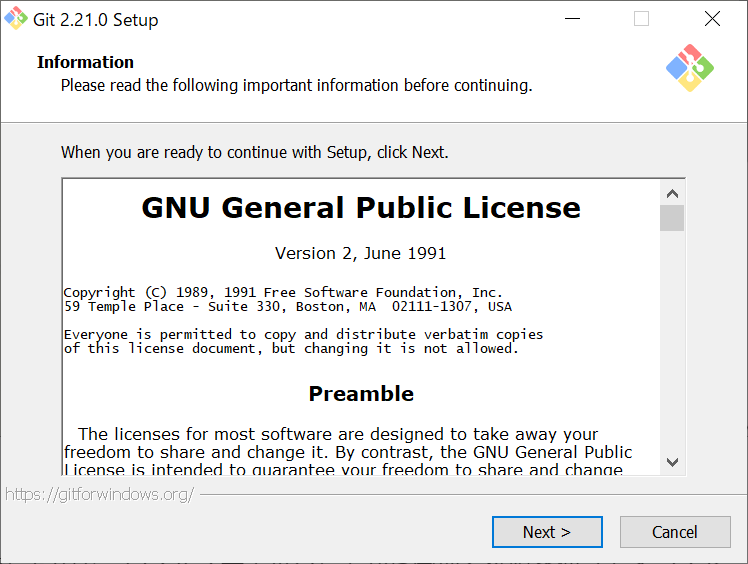

クリックすると、勝手にダウンロードが始まりました。「Git-2.21.0-64-bit.exe」がダウンロードされましたので、ウィルスチェックしてから管理者権限を使ってインストールします。ユーザ制御は当然OKしました。

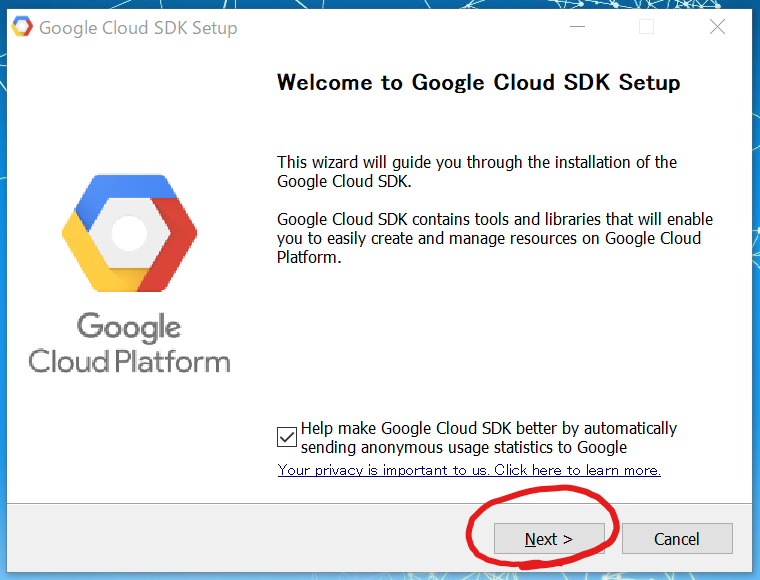

「Next >」をクリックします。

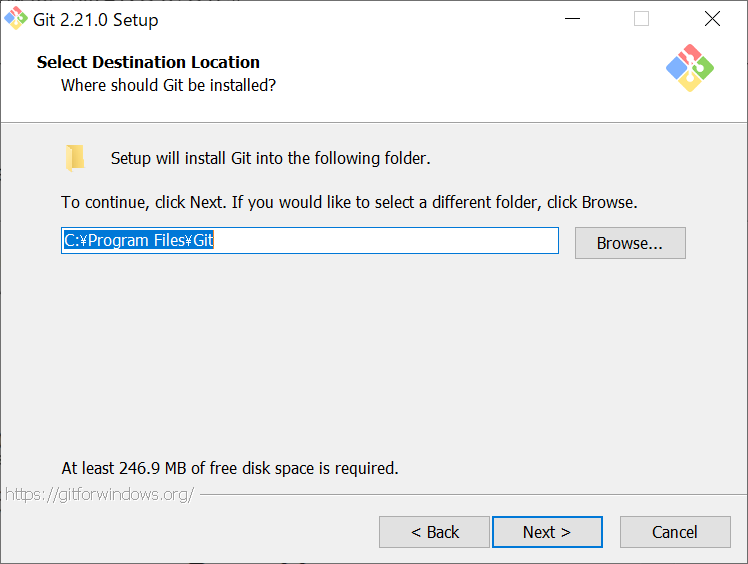

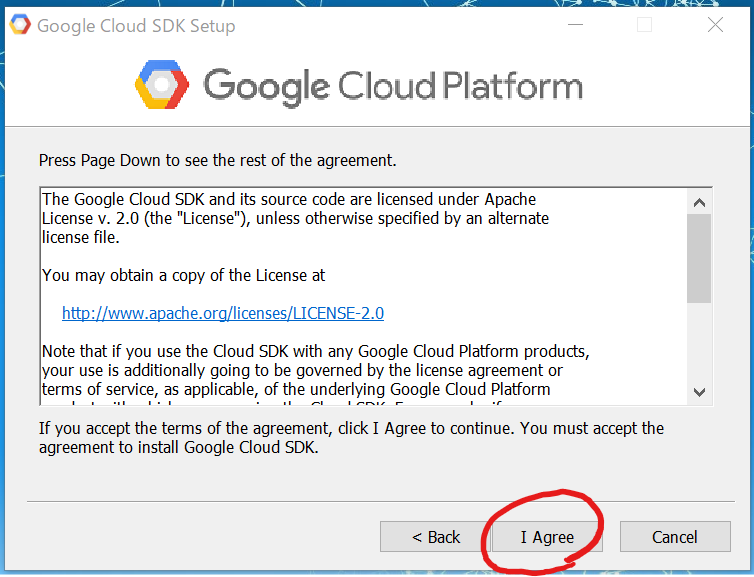

再度、「Next >」をクリックします。

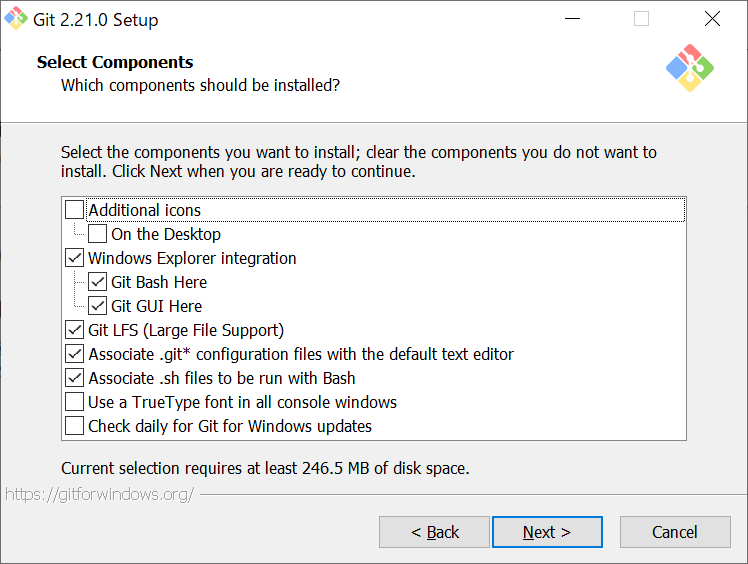

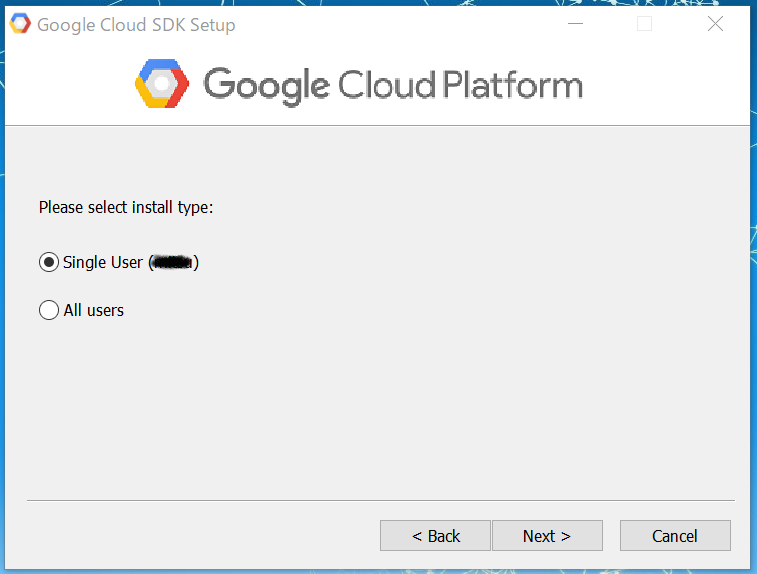

これも初期値でよさそうです。「Next >」をクリックします。

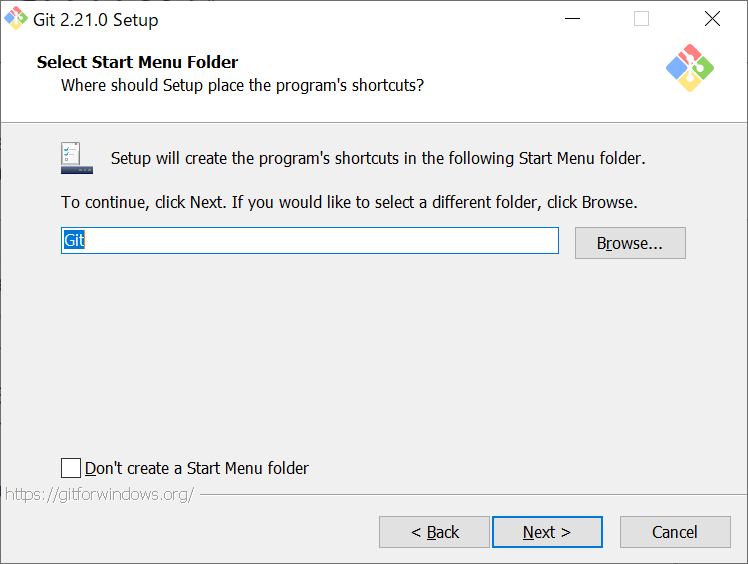

スタートメニューのフォルダについて聞いてきました。特に変える理由もないので、そのままにして「Next >」をクリックします。

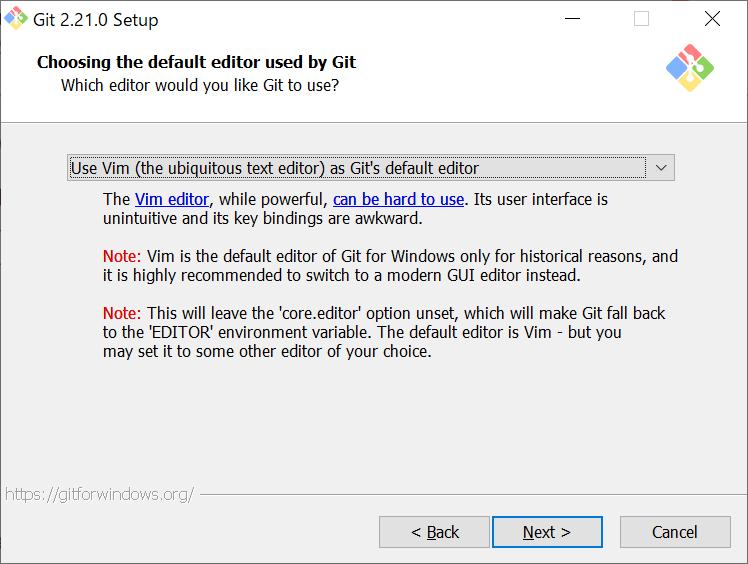

はい、次はデフォルトエディタを選んでください、と、言ってきました。ぼくはどちrかというとVimエディタが大好きなので、このまま「Next >」をクリックします。Vimエディタのこと知らない、とか、使いにくい、というひとは変える必要がありますね。

選択肢としては、「the Nano」「Notepad++」「Visual Studio Code」「Visual Studio Code Insider」「Sublime」「Atom」「その他」となっていました。世界のエディタ情勢はこんな感じなのですね。サクラエディタが入っていません。

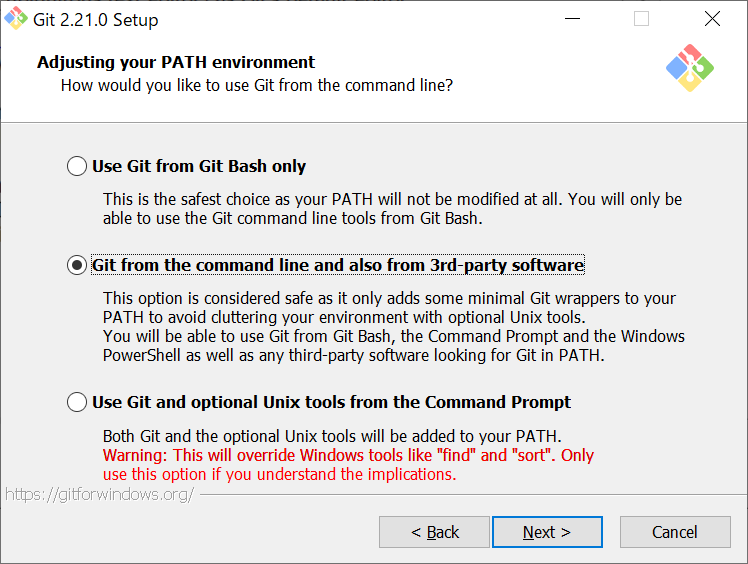

次は環境変数のPATHについての質問です。ここもデフォルトで問題なさそうです。「Next >」をクリックします。

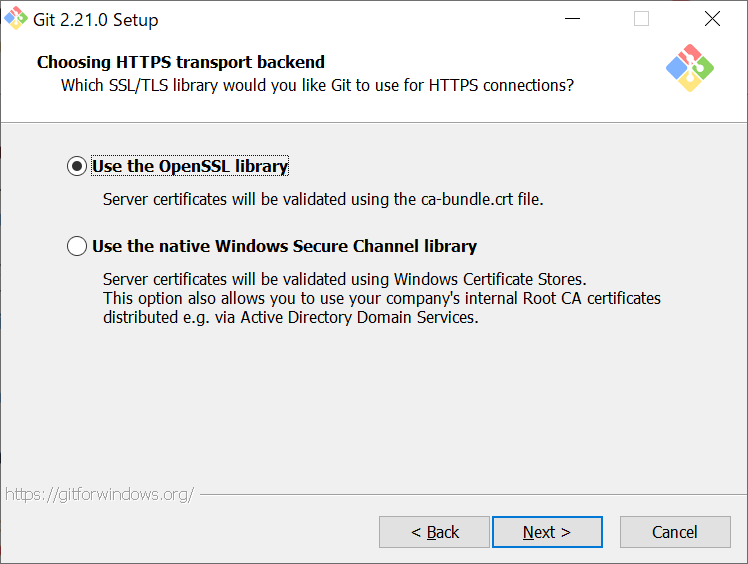

HTTPSで接続するときに使うライブラリを選択します。特に認証サーバーとか使う予定はないので、デフォルトのままで問題ないでしょう。「Next >」をクリックします。

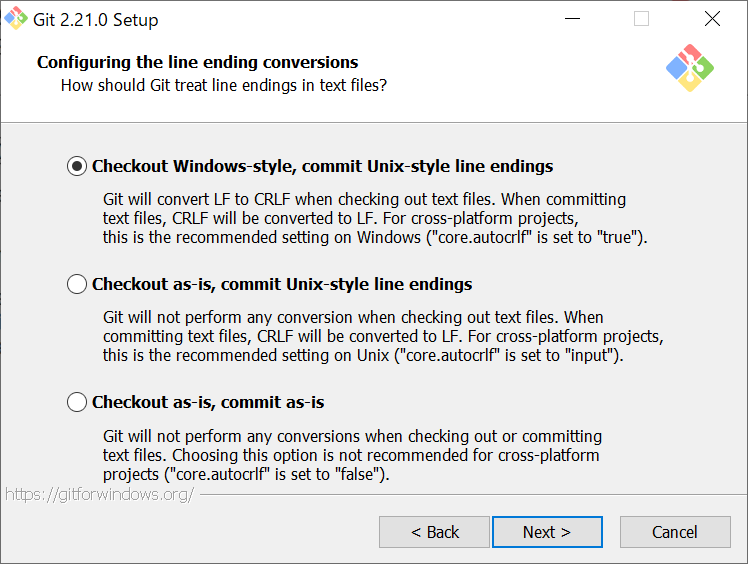

テキストファイルの改行文字の設定ですね。デフォルトのままで。「Next >」をクリックします。

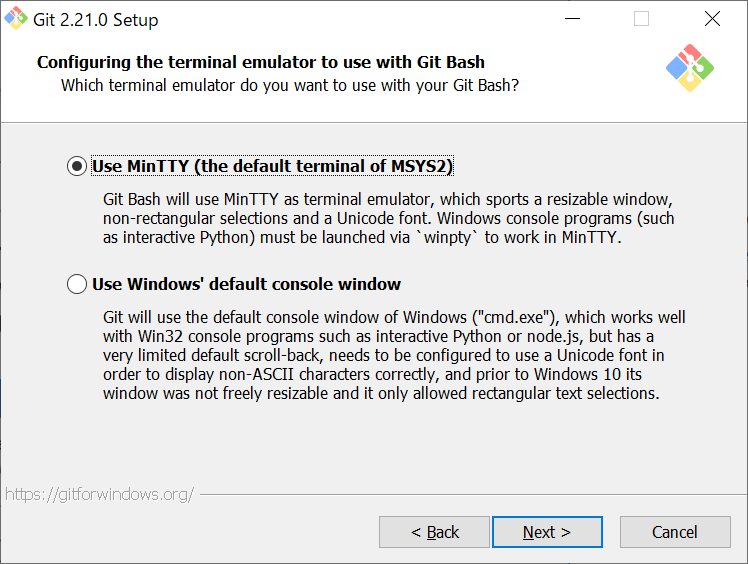

コンソールをどうするか、という設定ですね。特にこだわりがないので、デフォルトのままで「Next >」をクリックします。

だんだんうんざりしてまいりました。。。いや、いかん、気を取り直して。

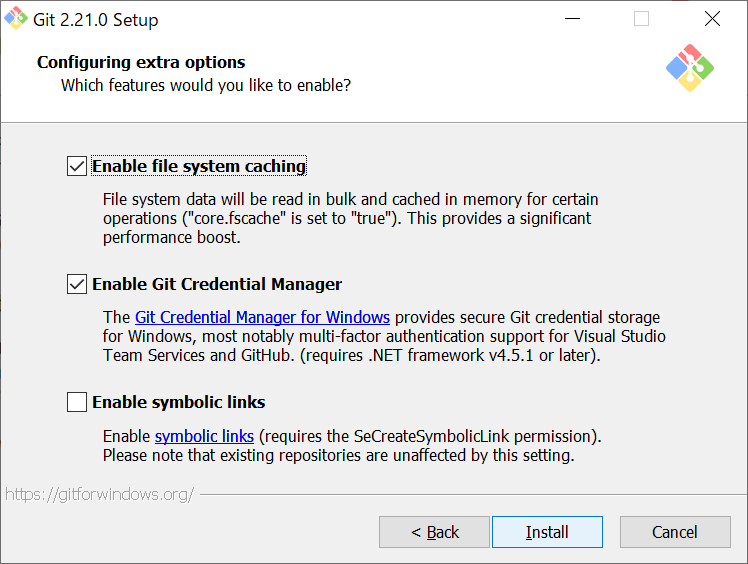

さあ、エクストラオプションですよ!

キャッシュ、使いましょう、スピードを速くしてくれるんでしょ。Git Credential Manager使いましょう、きっと認証が楽になるんでしょ。シンボリックリンク、うん、使わなくてもいいね、Windowsだし。で、「Install」をクリックします。おお、やっとインストールできます♪

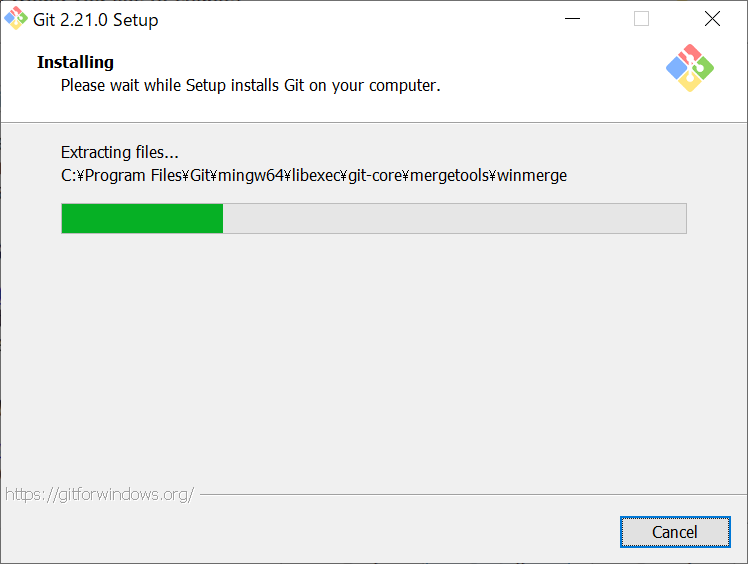

そして、、、1分もしないうちに以下の画面が表示されました。

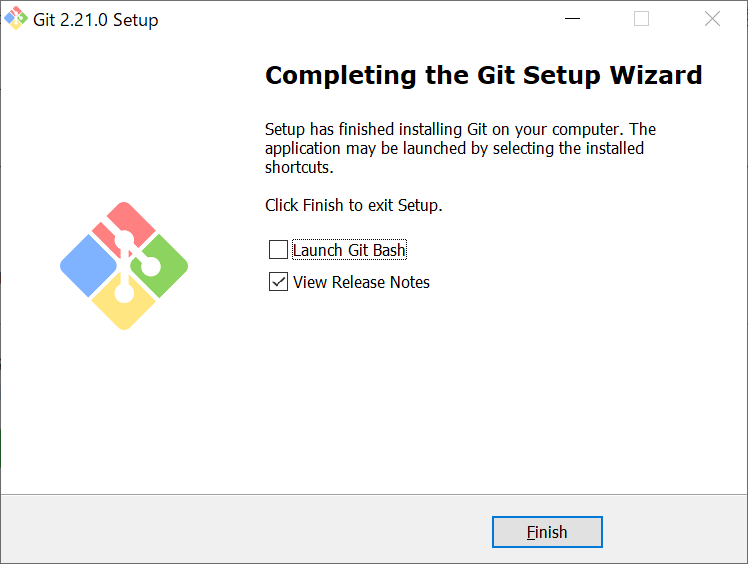

Finish!フィニーッシュッッッ!

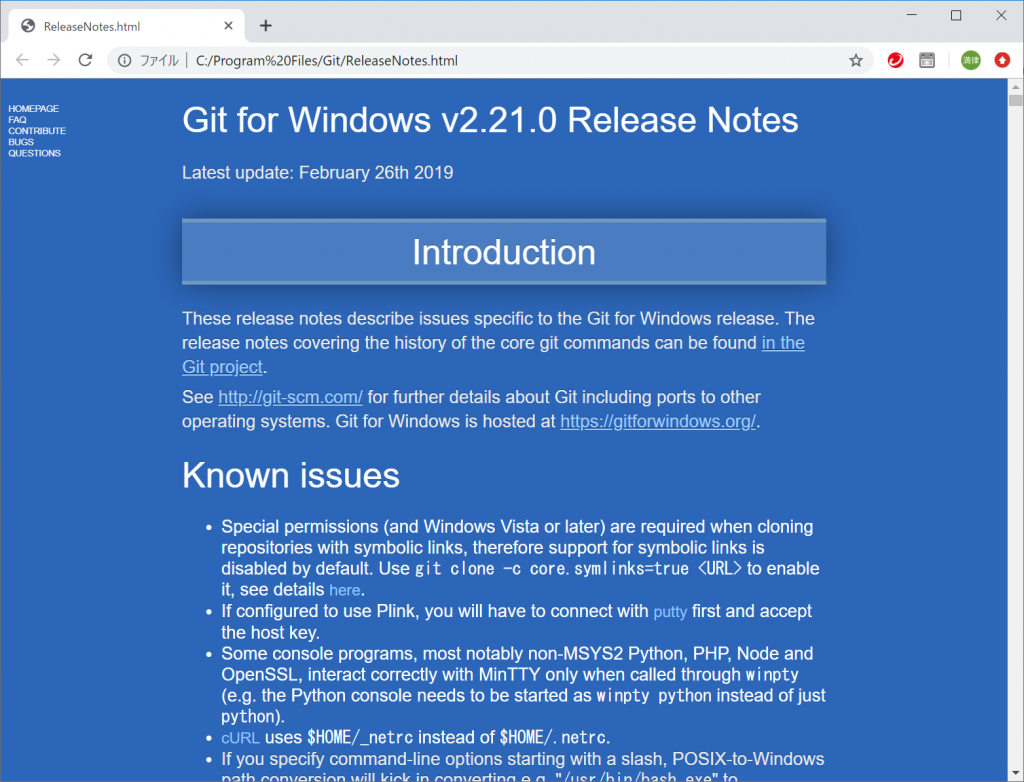

あ、リリースノートがブラウザに表示されました。確かに「View Release Notes」にチェック入れたままでしたね。なるほど、インストール先のフォルダにReleaseNotes.htmlファイルがあるのですね。あとでじっくり読むことにしましょう。

そして、システム必要要件がクリアできたので、やっと次ですね。

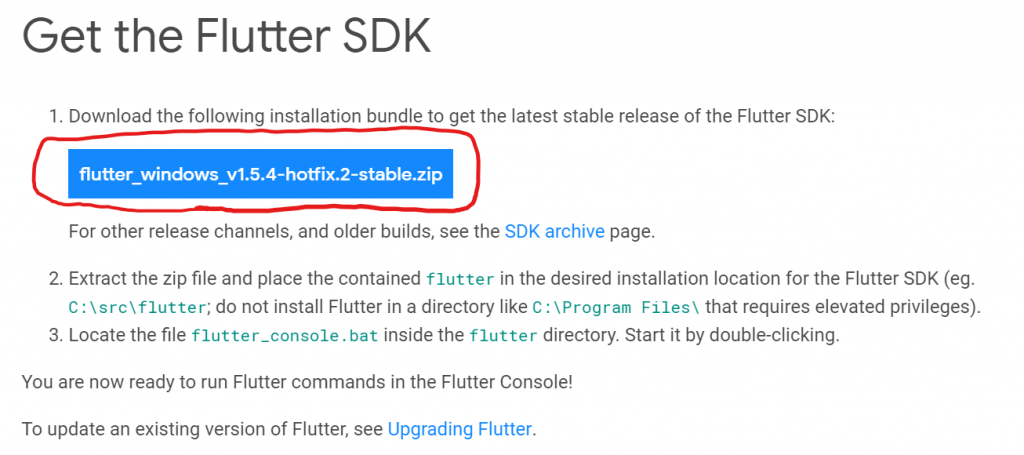

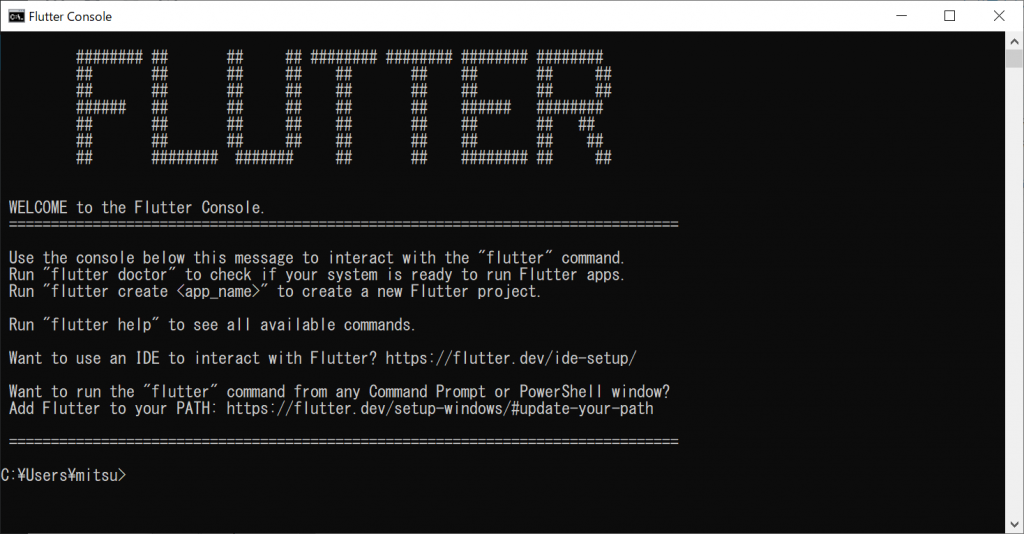

上のボタンをクリックすると、「flutter_windows_v1.5.4-hotfix.2-stable.zip」ファイルがダウンロードされます。念のため、ウィルスチェックしておきましょう。そして、これを自分の好きなフォルダに解凍します。ぼくは、「C:\Flutter」にしようかな。Program Filesは高い権限が必要になるのでインストールしないでと書いてあるので気を付けましょう。そして、flutter_consle.batをダブルクリックして終了、ということですね。

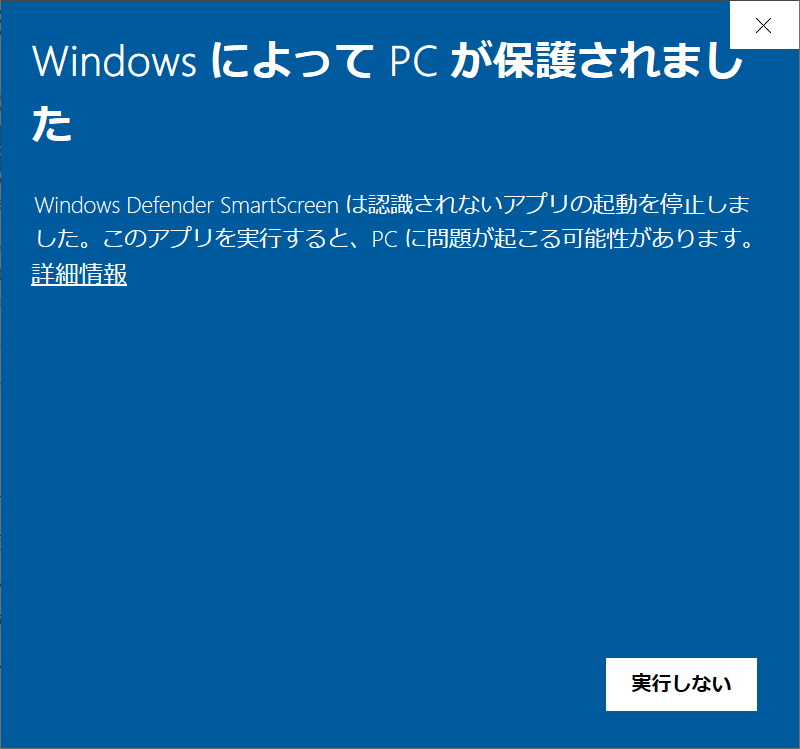

これは、保護じゃなくて、実行しますよ。中身を確認したけど、パスを追加して管理者権限でコマンドプロンプトを出しているだけですから。「詳細情報」をクリックします。

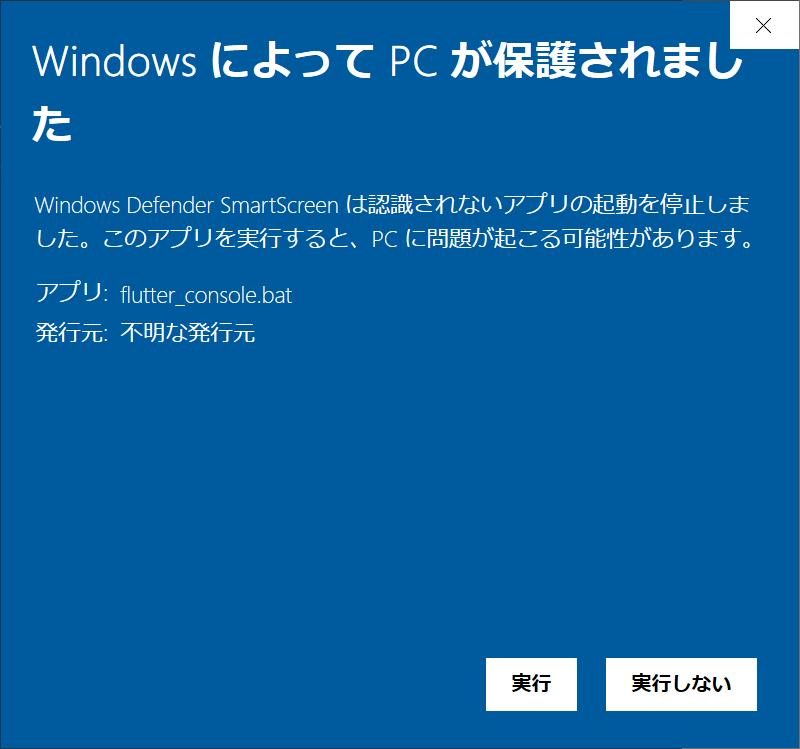

ボタンが現れましたので、「実行」をクリックします。

はい、実行されました。ちょっと長くなってきたので、続きは次回に。